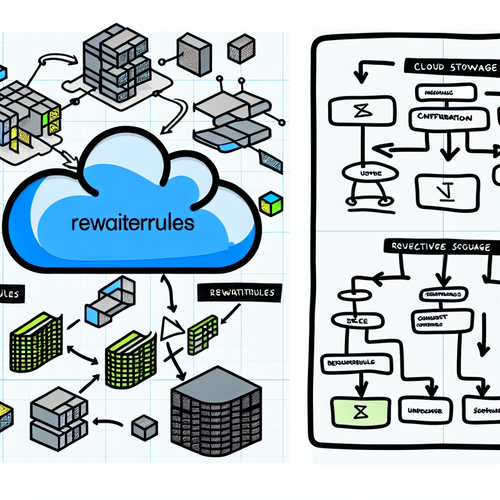

Die unsichtbare Stolperfalle: Warum Ihre Homepage-Rewrite-Rules dringend einem SEO-Check bedürfen

Stellen Sie sich vor, Ihre Hausnummer ändert sich ständig, aber Ihr Name am Briefkasten bleibt gleich. Lieferanten finden Sie nur durch Zufall. Genau dieses Chaos verursachen fehlerhafte Rewrite-Rules auf Ihrer Homepage für Suchmaschinen. Dabei geht es nicht um Basishygiene, sondern um existenzielle Sichtbarkeit.

Die Achillesferse der Crawlbarkeit

Technisch betrachtet sind Rewrite-Rules die Verkehrsregeln Ihres Servers. Sie lenken Anfragen um, verwandeln kryptische URLs in lesbare Pfade und sollen eigentlich Ordnung schaffen. Doch in der SEO-Praxis beobachte ich regelmäßig, wie gut gemeinte Regeln Crawler in Sackgassen führen. Ein klassisches Beispiel: Die scheinbar harmlose Regel, die sowohl example.com als auch www.example.com auf https://www.example.com leitet – theoretisch korrekt. Wenn aber parallel eine zweite Regel die Homepage zusätzlich unter /home erreichbar macht, entstehen Duplicate-Content-Fallen. Google crawlt vier Varianten derselben Seite, wertet Linksignale ab und Ihre Rankingkraft verpufft im Nichts.

Die tödlichen Sünden im .htaccess-Dschungel

Apache- und Nginx-Konfigurationen entwickeln oft ein Eigenleben. Besonders tückisch sind drei Fehlermuster:

1. Die Endlosschleifen-Falle: Ein Client wird zwischen Regel A und Regel B hin- und hergereicht wie ein Hot Potato. Crawler brechen nach wenigen Sprüngen ab – Ihre tiefen Inhalte bleiben unentdeckt. Ich erinnere mich an einen E-Commerce-Fall, bei dem 72% der Produktseiten durch einen einzigen fehlerhaften Regex-Ausdruck unsichtbar blieben.

2. Der Canonical-Kollaps: Wenn Ihre Regeln das Canonical-Tag unterdrücken oder falsch setzen, behandelt Google Shop-Kategorien plötzlich als identisch mit Blogposts. Das Ergebnis? Rankings stürzen ab wie Steinbrocken.

3. Der Mobile-Split: Separate Regeln für mobile Endgeräte, die auf m.example.com umleiten, zerstören seit Mobile-First-Indexing systematisch Ihre Domain Authority. Ein Relikt aus den 2010ern, das erstaunlich oft überlebt hat.

Prüfwerkzeuge: Mehr als nur Validatoren

Natürlich kennen Sie den Google Search Console-URL-Prüfer. Doch der zeigt nur Symptome, nicht die Systemerkrankung. Effektive Diagnose erfordert drei Werkzeuge im Verbund:

Crawler-Simulationen mit Tiefgang: Tools wie Screaming Frog oder Sitebulb müssen mit echten Crawler-Profilen gefüttert werden. Setzen Sie die User-Agents von Googlebot (Desktop/Mobile) explizit und analysieren Sie die HTTP-Header-Antworten jeder URL. Achten Sie auf Status-Codes 200 bei Duplikaten oder 301/302-Ketten länger als drei Hops.

Logfile-Forensik: Serverlogs verraten, was Suchmaschinen wirklich sehen. Filtern Sie nach Googlebot-Requests und prüfen Sie, welche URLs tatsächlich angefragt werden. Oft zeigt sich: Crawler folgen Ihren internen Links ganz anders als gedacht – weil Rewrite-Rules die Pfade verzerren.

Die Redirect-Map: Bauen Sie eine komplette Abbildung aller URL-Varianten und ihrer Weiterleitungsziele. Open-Source-Skripte wie Python-Requests in Kombination mit BeautifulSoup automatisieren dies. Ein Pharma-Kunde entdeckte so 1.200 tote Redirects, die 14% seines Crawling-Budgets fraßen.

AdWords-Fallout: Wenn Technik Werbebudgets verbrennt

Hier schließt sich der Kreis zum Paid Advertising: Angenommen, Sie leiten in AdWords-Kampagnen auf example.com/angebot – doch Ihre Rewrite-Rules zwingen einen Umweg über example.com/home?redirect=angebot. Jede zusätzliche Millisekunde Ladezeit kostet nach Akamai-Studien bis zu 7% Conversion-Rate. Schlimmer noch: Wenn der finale URL-Parameter nicht im Google Ads-Tracking erfasst wird, verlieren Sie die Zuordnung von Klicks zu Conversions. Ihr Optimierungshebel ist dann stumpf.

Modernes Regel-Handling: CDNs und Serverless-Architekturen

Die Cloud hat Rewrite-Management revolutioniert – und verkompliziert. Bei CDNs wie Cloudflare oder AWS CloudFront werden Regeln oft über GUIs verwaltet. Das birgt Risiken:

Cache-Invalidation: Ändern Sie eine Regel, bleibt die alte Version oft Stunden im CDN-Cache. Tipp: Erzwingen Sie sofortige Invalidierung oder nutzen Sie Versioning für Regel-Sets.

Lambda@Edge-Fallen: AWS erlaubt Rewrites via Lambda-Funktionen. Elegant, aber wenn Ihr Code 500er-Fehler wirft, sieht Google nur „Server Error“. Legen Sie immer Fallback-Routen zu statischen URLs an.

API-Gateways: Bei Headless-Shops werden Produkt-URLs oft durch API-Endpoints generiert. Prüfen Sie, ob die Routen konsistent mit der sitemap.xml übereinstimmen. Diskrepanzen hier sind häufiger als vermutet.

Der große SEO-Rewrite-Check: Schritt für Schritt

So gehen Profis vor:

1. Bestandsaufnahme: Sammeln Sie alle Regel-Dateien (.htaccess, nginx.conf) und CDN-Konfigurationen. Dokumentieren Sie jede einzelne Regel mit Kommentaren.

2. Testumgebung: Spielen Sie Änderungen niemals direkt live. Nutzen Sie Staging-Server mit identischer Konfiguration.

3. Kanonische Festlegung: Definieren Sie genau eine bevorzugte URL-Struktur (Trailing Slash? Groß-/Kleinschreibung?).

4. Regel-Priorisierung: Ordnen Sie Regeln nach Wichtigkeit. URL-Bereinigung vor Sprachumleitungen vor Custom-Routes.

5. Monitoring: Implementieren Sie Alerts für 404/500-Fehler in Google Search Console und via Logging.

Ein Praxisbeispiel: Ein Reiseportal hatte eine Regel, die URLs mit Umlauten (/grüne-strände) in Kodierungen (/gr%C3%BCne-str%C3%A4nde) umwandelte. Konsequenz: Externe Links verweisen auf die schöne Version – aber Ihre interne Verlinkung nutzte die kodierte Variante. Der Linkjuice wurde geteilt, Rankings sanken. Die Lösung war eine 301-Redirect-Kette zur dekodierten URL.

Die Zukunft: Intelligente Rules durch Machine Learning?

Erste CDN-Anbieter experimentieren mit KI-gesteuerten Rewrite-Optimierungen. Systeme analysieren Crawling-Muster und passen Regeln dynamisch an, um Crawling-Budget zu sparen. Doch Vorsicht: Vollautomatik kann neue Fehler generieren. Meine Empfehlung: Nutzen Sie ML als Analyse-Tool, behalten Sie aber die manuelle Kontrolle über Kernregeln. Denn am Ende entscheidet Ihre URL-Struktur darüber, ob Suchmaschinen Ihre Inhalte als wertvolle Ressource oder chaotisches Labyrinth einstufen.

Fazit: Rewrite-Rules sind keine „Set-and-Forget“-Technik. Sie sind lebende Infrastruktur – so dynamisch wie Ihre Inhalte. Ein halbjährlicher SEO-Audit dieser unscheinbaren Codezeilen bewahrt Sie vor Ranking-Desastern, die erst bemerkt werden, wenn es zu spät ist. Denn im digitalen Raum gilt: Wer nicht auffindbar ist, existiert nicht. Und oft liegt der Teufel im technischen Detail.